Estrutura de Dados #1

Já faz um tempo que não escrevo sobre esse assunto mas, antes tarde do que nunca 🤝

Continuando da onde eu parei (Estrutura de Dados #0) hoje eu quero falar sobre Complexidade de Algoritmos e por que você deveria pensar duas vezes antes de colocar um While/for dentro do outro.

Já deixando um disclaimer, eu não sou nenhum professor universitário que entende 100% do assunto, sou só um estudante que gostou da matéria Estrutura de Dados :).

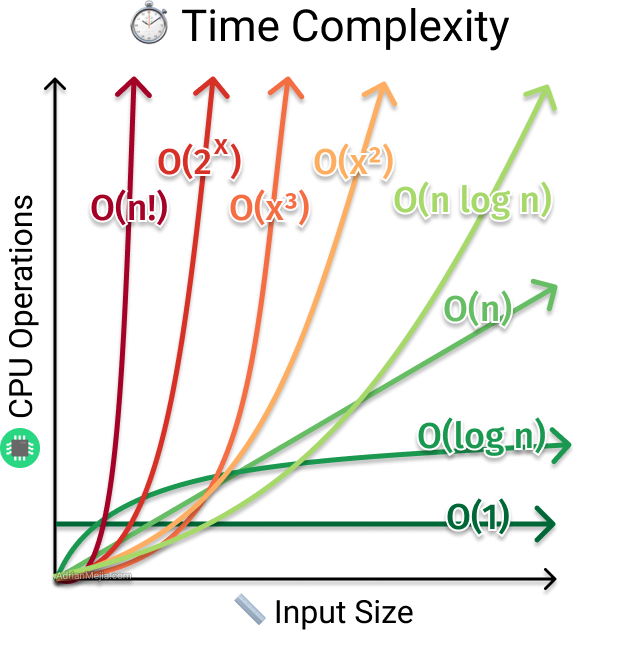

O estudo de Complexidade de Algoritmos envolve analisar o tempo de execução de determinado algoritmo e por isso, esse assunto também pode ser chamado de Tempo de Complexidade ou em English - Time Complexity. A importância de se estudar quanto tempo seu algoritmo levará pra ser executado numa determinada situação parece ser bastante auto explicativa, mas dando um exemplo, imagine que você é um(a) engenheiro(a) de software da Twitch e que agora você precise ordenar todos os canais online baseado no número de espectadores de cada canal. Dependendo da forma que você faça isso, talvez o seu algoritmo leve muito tempo para terminar a execução gastando muito recurso de processamento, e levando em consideração que estamos falando de uma grande empresa com muitos usuários e muitos dados, isso seria bem ruim. Nesse caso, você teria que antes mesmo de começar a escrever qualquer código, analisar como o algoritmo se comportaria no pior caso possível e essa analise é feita usando uma notação matemática (eu acho que exclusiva da computação) conhecida como Notação Big O, ou O Grande. A Notação Big O foca em analisar o comportamento do algoritmo no pior caso possível. Existem outras notações para melhor caso e caso médio, mas vamos ver aqui somente a Big O mesmo. Aqui são algumas exemplos:

- O(1) -> As instruções são constantes, independente do n° de elementos.

- O(n) -> No pior caso teremos n instruções e o crescimento é linear.

- O(n²) -> No pior caso teremos n² instruções e o crescimento é exponencial.

- O(log(n)) -> No pior caso teremos log2(n) = x, onde x é o n° de instruções e o crescimento é esse aqui da foto haha.

A forma como eu aprendi complexidade foi analisando algoritmos e é o que nós vamos fazer agora!

Trouxe aqui 3 algoritmos de ordenação bem conhecidos: Insertion Sort, Selection Sort, Bubble Sort :)

Para entender a complexidade de um algoritmo, precisamos entender o que ele faz e principalmente COMO ele faz. Então começando pelo Insertion Sort, vamos escrever em poucas palavras o que ele faz e como, de uma forma que já nos de a resposta da complexidade

- Insertion Sort: Para cada elemento, busca-se a posição correta no vetor. Ou seja,

para cada N elementos temos que percorrer N posições, Logo, sua complexidade é O(n²).

Perceba que nós chegamos na complexidade sem escrever nenhuma linha de código! basta dizer da forma certa o que ele faz e como. Vamos tentar com os outros.

- Selection Sort: Para cada posição, busca-se o elemento correto no vetor. Ou seja,

Para cada N posições temos que percorrer N elementos, Logo, sua complexidade é O(n²).

e por fim,

- Bubble Sort: Para cada par de elementos, busca-se a posição correta relativa no vetor. Ou seja,

Para cada N pares de elementos temos que percorrer N posições, Logo, sua complexidade é O(n²).

Só com base nessas simples frase, qualquer pessoas que não seja um programador chaves haha, consegue implementar os algoritmos acima em QUALQUER LINGUAGEM! Inclusive, recomendo fortíssimo vocês implementarem esses algoritmos até pra entenderem o que eu falei lá no início, fica aí o desafio.

Exercitem essa dica de resumir o algoritmo em poucas palavras já deixando claro a complexidade e se quiserem, respondam aqui como fizeram 😁

Alguns materiais adicionais:

Insertion Sort 💃

Selection Sort 💃

Bubble Sort 💃