Big techs embutem mensagens secretas em conteúdos de IA, mas elas podem ser adicionadas e removidas arbitrariamente

Fala, galera!

Estive trabalhando em um projeto envolvendo mecanismos de watermarking modernos, baseados em inteligência artificial e projetados para serem imperceptíveis aos olhos humanos. Ou seja, sistemas como o TrustMark da Adobe, o Watermark Anything (WAM) da Meta e o SynthID da Google.

No processo, fiz algumas observações que, no meu entender, merecem ser apresentadas e discutidas publicamente, posto que é relevante para como a sociedade pretende lidar com os desafios trazidos pela evolução da IA generativa.

Contexto

Watermarking virou política pública. Governos e indústria têm promovido a tecnologia — que coincidentemente é também excelente para rastrear quem disse o quê, quando e onde — como um componente essencial no combate contra campanhas de desinformação assistidas por IA.

No próximo ano, entrará em vigor o Artigo 50 do AI Act, medida regulatória da União Europeia que estabelece regras para provedores de inteligência artificial generativa. Dentre as obrigações, encontra-se o watermarking de “conteúdo sintético”, como áudio, imagens, vídeos e textos gerados por IA.

A Content Authenticity Initiative (CAI) e a C2PA (Coalition for Content Provenance and Authenticity), lideradas por Adobe, Microsoft, BBC e outras, estão construindo uma infraestrutura de “Content Credentials” que se baseia parcialmente em watermarking. O objetivo declarado é criar uma “camada de confiança” pra internet, onde você pode verificar a origem de qualquer mídia digital.

Difusão

Enquanto eu realizava a leitura do paper da Adobe sobre o TrustMark (arXiv:2311.18297), tive uma sacada.

Como parte do projeto, a Adobe treinou os seus próprios modelos para a remoção da watermark criada pelo TrustMark. No paper, na Página 2, Seção 3 (“Methodology”), os pesquisadores escreveram:

We treat watermarking and removal as 2 separate problems, since the former involves trading-off between two data sources (watermark and image content) while the latter resembles a denoising task.

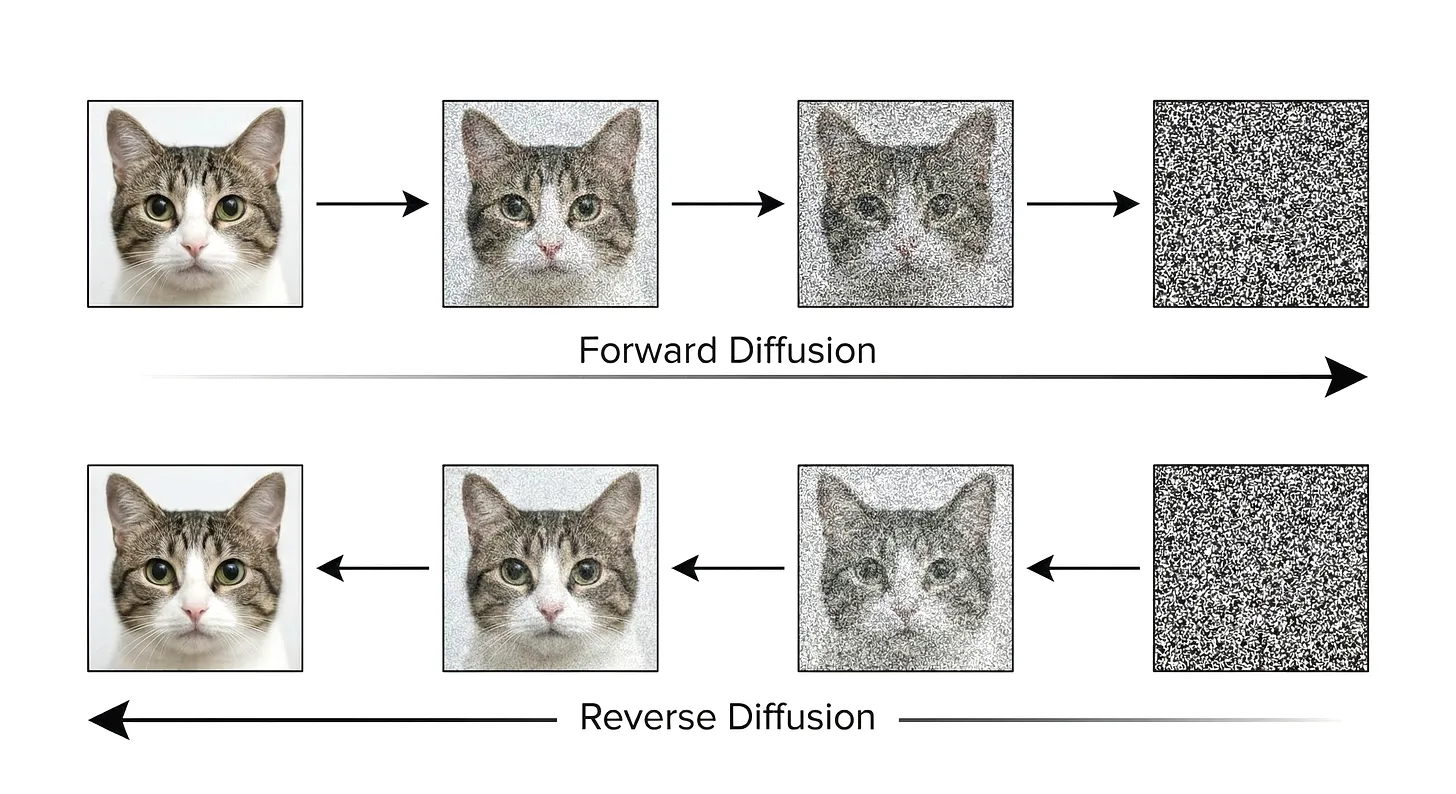

Me perguntei: se a remoção de watermarks é fundamentalmente uma tarefa de denoising, não seria altamente efetivo utilizar para esse propósito modelos de difusão treinados em geração de imagens? Afinal, eles são as ferramentas mais poderosas de denoising já criadas.

Experimentos

Para os testes, busquei selecionar uma imagem que dificilmente teria sido gerada por IA. Optei por usar o recorte de um dos frames do vídeo 【OSHI NO KO】 Season 3 | Official Trailer 2 | Crunchyroll, disponível no YouTube. Posteriormente, utilizando um modelo baseado na arquitetura do SDXL (WAI-Illustrious-SDXL v15) com uma configuração bem simples (28 steps, start step 27, euler_ancestral, add_noise desabilitado), consegui remover as marcas d'água dos três sistemas:

TrustMark (Adobe): Um passo de difusão e o payload que havia sido embutido simplesmente sumiu. A imagem resultante inclusive ficou com qualidade visual superior à do modelo oficial de remoção da própria Adobe.

Watermark Anything (Meta): Um passo reduziu a acurácia de bits de 100% pra 56% (praticamente ruído aleatório). Dois passos e a saída ficou idêntica à de uma imagem sem marca d'água.

SynthID (Google): Um passo e o detector público do Google (via Gemini) não encontrou mais o watermark. Embora a resposta do Gemini tenha mencionado “inconsistências visuais geralmente encontradas em arte produzida por IA” na imagem processada, houve a confirmação de que o SynthID não estava mais presente.

Preocupações

Obviamente, não sou o primeiro a descobrir métodos para reduzir ou eliminar a detecção de watermarks. Mas esses experimentos realmente fizeram com que eu me perguntasse: se é trivial tanto adicionar uma watermark (e.g. SynthID) em conteúdo arbitrário quanto removê-la de conteúdo sintético, então para que realmente serve o sistema?

Eu argumentaria que se trata não apenas de um mecanismo falho, como também potencialmente perigoso. A implementação de sistemas de rastreamento de origem de conteúdo trazem graves riscos à privacidade, remetendo aos infames tracking dots das impressoras a laser. Mas vai além: a própria proposta de uso de watermarks no combate à desinformação pode tornar-se arma nas mãos de atores maliciosos.

Imaginemos um possível cenário: um funcionário desatisfeito de uma campanha política obtém uma fotografia real de um comício, injeta a watermark do SynthID na imagem, e a publica nos canais oficiais.

Então, ele envia uma denúncia anônima a um jornalista: “a campanha X está usando imagens de IA”. O jornalista verifica a imagem utilizando o detector oficial da Google, que detecta a watermark, julga que a denúncia “procede”, e publica matéria.

No fim das contas, a verdade poderia até ser provada através da foto original, de uma investigação forense, de testemunhas e afins. Mas quanto tempo levaria até isso acontecer? Certamente mais do que o necessário para evitar danos à credibilidade da vítima.

Pior: o AI Act e outras regulações esperam que watermarks ajudem a identificar deepfakes pornográficos. Mas, com as marcas sendo trivialmente removíveis, o efeito pode ser contrário. O conteúdo sintético, passado como verdadeiro sob o argumento da ausência de watermarks, poderia ser transformado em casos de revenge porn.

Todos os detalhes dos experimentos, incluindo as informações necessárias para reproduzí-los e os arquivos utilizados, estão disponíveis na publicação original.